В рамках проекта перед нами стояла задача организовать автоматизированный сбор и глубокий анализ большого объема данных о вакансиях с множества разнородных источников, как российских, так и европейских. Основная сложность заключалась в необходимости работать с ресурсами, которые кардинально отличались друг от друга: предоставляли информацию в разном объеме и структуре, использовали различные технологии защиты и форматы представления данных. Это требовало создания не просто парсера, а универсальной, устойчивой и адаптивной системы.

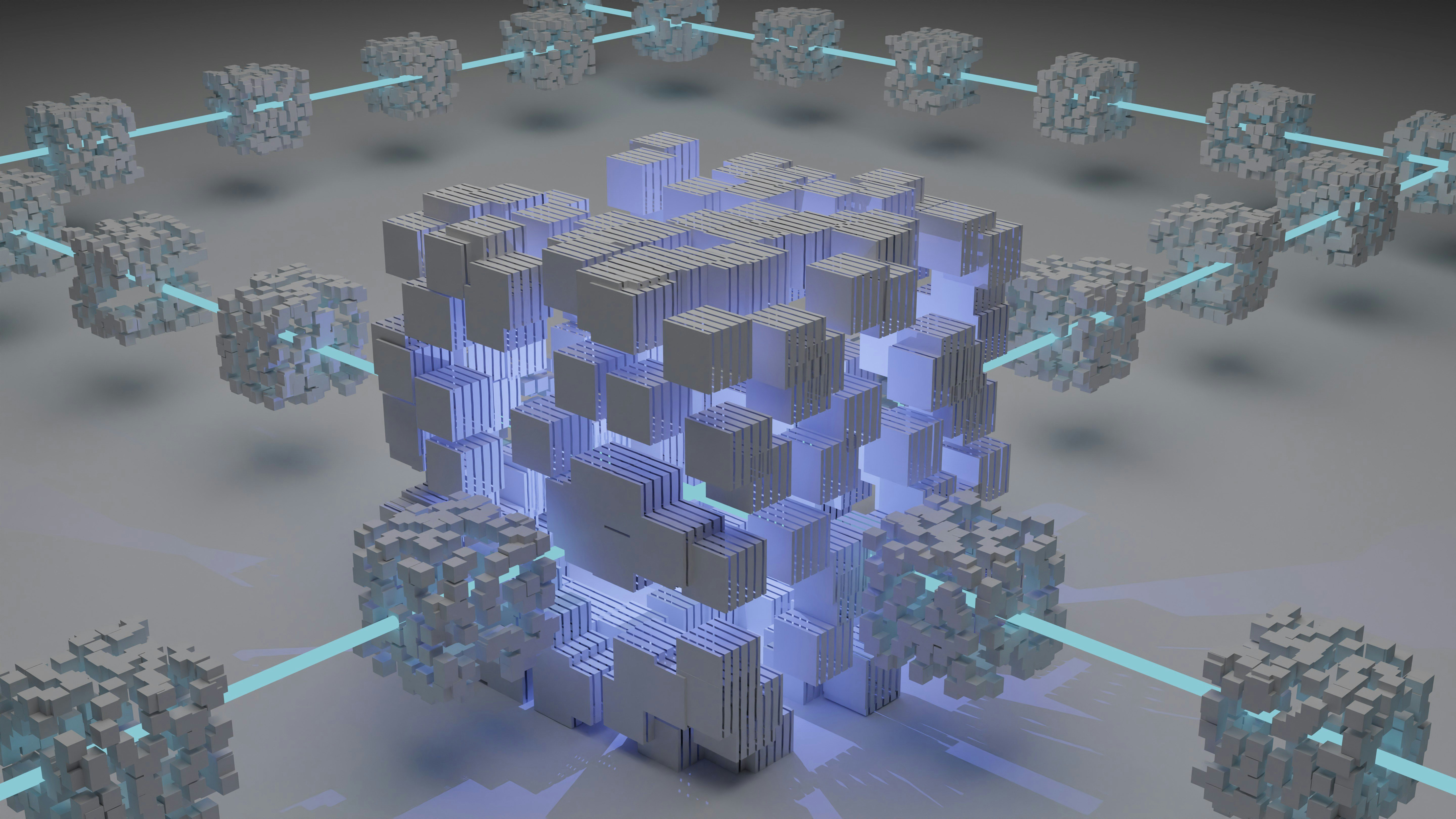

Для решения этой задачи была разработана горизонтально масштабируемая система, в которой логика сбора данных была четко отделена от логики их агрегации и аналитической обработки. Такой подход обеспечил высокую гибкость, отказоустойчивость и возможность независимого масштабирования компонентов.

Ядром системы стал центральный управляющий модуль, который координирует работу распределенных роботов-сборщиков. Для взаимодействия с каждым внешним ресурсом были разработаны специализированные роботы, оснащенные различными движками и интегрированные со сторонними сервисами для эффективного извлечения данных.

Управляющий модуль интеллектуально распределяет задачи, взаимодействует с прокси-сервисами для обеспечения анонимности, а также обогащает сырые данные дополнительной информацией из внешних API. Важной частью архитектуры стала интеграция с LLM-моделями (ИИ), которые используются для быстрой очистки, структурирования и извлечения ключевых смыслов из неоднородных текстов, обеспечивая оптимальное соотношение стоимости и качества обработки.

Полученные и обогащенные данные агрегируются, анализируются и становятся доступными для углубленного изучения через API для сторонних BI-систем. В результате мы создали не просто сборщик данных, а вертикально и горизонтально масштабируемую аналитическую платформу, способную адаптироваться к изменяющимся требованиям и постоянно эволюционирующим системам защиты внешних источников.

Мы успешно решили следующие ключевые задачи:

Результатом нашей работы стала высокопроизводительная система, способная в автоматическом режиме оперировать большими массивами разнородных данных. Ключевыми достижениями стали полная автоматизация цикла, от планирования и сбора до очистки, обогащения и агрегации информации без ручного вмешательства. Реализованная архитектура обеспечивает быструю обработку тысяч вакансий ежедневно с высокой устойчивостью к сбоям. Благодаря интеграции с LLM, система не просто собирает данные, но и “понимает” их, выделяя суть, категории и ключевые параметры, превращая разрозненную информацию в структурированные аналитические срезы. Использование встроенного планировщика задач позволяет легко настраивать процессы, а сама система быстро адаптируется под новые источники и изменяющиеся требования. В качестве готовой аналитической платформы система предоставляет удобный API-доступ к очищенным данным для их последующей визуализации и углубленного анализа в BI-инструментах, что дает заказчику мощный инструмент для принятия решений.

Django, Python, Selenium, Beautiful Soup, Scrapefly, OpenAPI, OpenAI, FastAPI, REST API, React JS, PostgreSQL, MongoDB, Suite CRM Integration

Обработка данных в сутки: 2-3 тысячи вакансий

Количество внешних источников: 12 сайтов

Скорость сбора и первичной обработки: до 250 записей в час

Накопленный объём структурированных данных: свыше 200 тысяч записей (за 4 месяца работы)

Команда проекта: 4 человека

Затрачено часов: 120

Сложность проекта: 8 из 10